Осторожность Google в отношении стороннего ознакомления с Project Glass означает, что пользовательский интерфейс носимого компьютера в большинстве своём остаётся загадкой. Однако новая заявка на патент может раскрыть некоторые секреты. Под заголовком «Головной экран, графически отображающий физическое взаимодействие с интерфейсом ввода, расположенным за пределами обзора» описывается то, что видит пользователь при управлении с помощью сенсорной панели, встроенной в дужку очков.

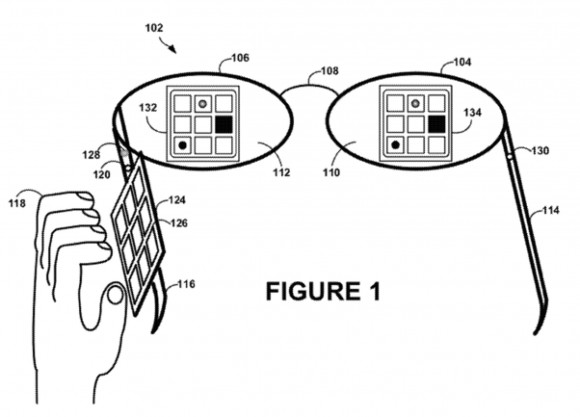

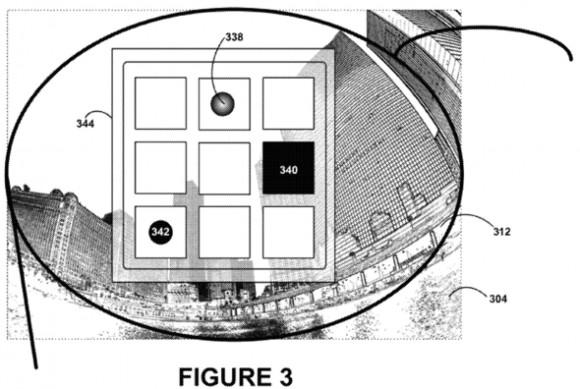

Патент раскрывает подход, при котором пользователь использует сенсорную панель в форме сетки кнопок 3х3, обладающей соответствующей текстурой. Аналогичное изображение выводится на очки. Google указывает на возможность сенсорной панели воспринимать не только касания, но и приближение пальцев на близкое расстояние, что позволит легче выбирать нужную команду — во время приближения будут подсвечиваться соответствующие кнопки.

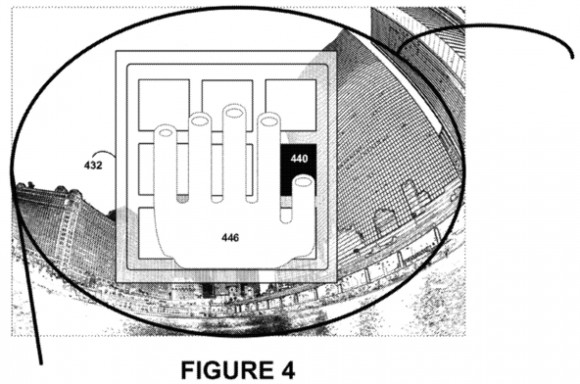

Технология считывания с помощью встроенной в сенсорную панель камеры позволяет выводить на экран и точное изображение руки человека для более естественного и простого управления. При этом у пользователя создаётся впечатление, что он взаимодействует с блоком кнопок прямо перед собой.

Подобное управление, как известно, является не единственным способом, который Google предложит для взаимодействия с Glass — можно будет управлять голосом, через основную камеру или беспроводную клавиатуру и так далее. Какой из режимов будет применяться, зависит от каждого отдельного случая, предпочтений пользователя, а также условий эксплуатации. Для компании важно реализовать ряд альтернативных методов управления, способных эффективно заменять и дополнять друг друга.

Очки могут работать и в пассивном режиме, реагируя самостоятельно на происходящие вокруг пользователя события и звуки. Патент описывает такой сценарий: во время разговора Glass регистрирует имя человека, который занесён в список контактов, и выводит на экран информацию о нём. Или же может быть зафиксирован шум двигателя, а по известным образцам звука определено, что это машина пользователя Glass, тогда на экран будет выведена карта для удобства навигации.

Безусловно, будет широко использоваться и объединение данных различных сенсоров. Google приводит пример интеллектуального выбора метода управления на основе данных о погоде. Например, если сенсорная панель является предпочтительным методом ввода, но окружающая температура настолько низкая, что следует предположить наличие перчаток на руках пользователя, препятствующих сенсорному управлению, — Glass будет ожидать команд через микрофон.

Примечательно, что в качестве примеров голосового управления Google приводит команды запуска Word, электронной почты и веб-браузера, что может ясно свидетельствовать о широких возможностях управления в Glass, позволяющих набирать форматированный текст или осуществлять веб-сёрфинг.

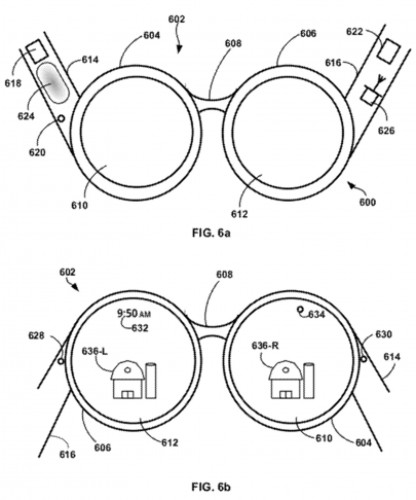

Google отмечает, что дизайн носимого компьютера Glass не завершён, конечный вариант может иметь экраны для обоих глаз, встроенные в стёкла или закрепляемые над ними. Экраны могут быть выполнены по технологии LCD или же направлять лазерный рисунок прямо на сетчатку глаза, а также применять другие технологии. Как уже было отмечено, последним новшеством стала вторая камера в сенсорной панели. Возможно, будет интегрирована и камера заднего вида.

Что касается аппаратной части, очки могут быть наделены собственной платформой, памятью и другими компонентами или использовать мощности подключённого мобильного устройства вроде смартфона.

Google уже приняла предварительные заказы на модель Glass Explorer Edition, поставки которой для разработчиков начнутся в начале 2013 года. Обычные пользователи должны получить намного более дешёвое предложение, чем цена в $1500, но примерно на год позже, когда будет налажено массовое производство.